使用虚拟分对数匹配的分布外检测

[Paper Download]

[Code Download]

[Project]

人工智能在行业的落地中面临开放世界识别的挑战。在大多数行业应用中,训练数据无法保证覆盖实际测试中的所有情况,模型对异常数据容易判断错误。Out-Of-Distribution (OOD) 检测算法正是解决这一问题。现有的OOD检测方法大多基于单一的输入信息:特征、logit或softmax概率,然而单一的信息无法应对分布多种多样的OOD样本。

在CVPR 2022上,商汤研究团队提出了名为Virtual-logit Matching (ViM) 的新型OOD检测方法[1],它巧妙地结合了类别无关的特征空间分数和In-Distribution (ID) 类别相关的logits分数,在多个测试集和网络结构上达到state-of-the-art效果。此外,论文还发布了当前最大的完全人工标注的OOD检测测试集OpenImage-O,是已知最大的OOD学术测试集的8.8倍。

问题和挑战

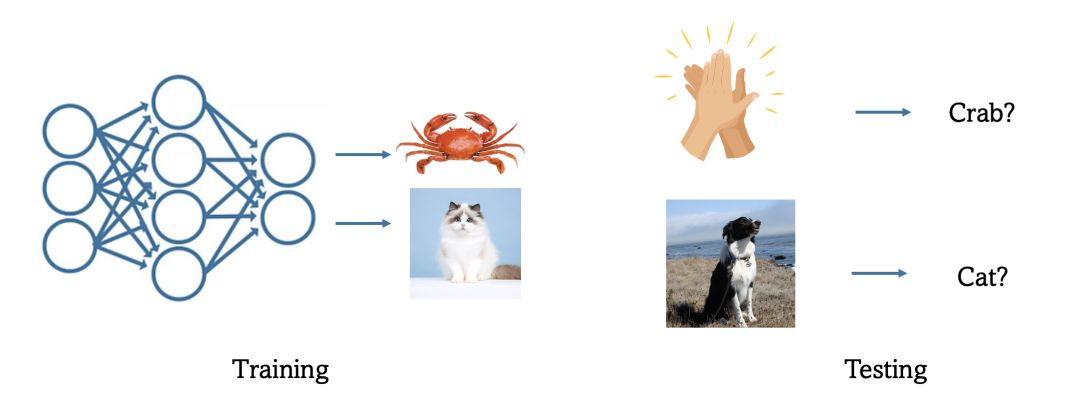

开放世界识别是人工智能在不同行业(如:自动驾驶、医疗、工业质检)的落地中必须要解决的共同问题 [3]。OOD检测问题正是检验开放世界识别的一个基准问题。一个直观的例子如下图:一个对于螃蟹和猫的分类网络,可能会把从未见过的拍手(在训练集数据分布之外的测试样本,out-of-distribution sample)错分为螃蟹,把从未见过的狗错分为猫。OOD detection算法是用来判断输入数据是否属于已有训练集分布的方法。由此,深度神经网络不会受到从未学习过的种类的样本的干扰。

|

一些OOD检测的算法需要额外数据进行重新训练。在ICCV 2021的《Semantically Coherent Out-of-Distribution Detection》[2]这一论文中,我们提出了利用海量无监督的数据训练来提升OOD检测的效果。这类方法需要有额外数据的支持。还有一些方法不需要额外数据,但需要重新训练网络。这类方法在使用便捷程度上不如无需再次训练网络的方法。

无需重新训练网络的方法按照OOD分数的信息源,可分为基于softmax概率的方法,如MSP [4],KL Matching [5];基于logit的方法,如MaxLogit [5],Energy [9];基于特征的方法,如Mahalanobis distance [7],NuSA [10];以及基于梯度的方法, 如GradNorm [11],ODIN [8];等等。现有的OOD检测方法大多基于单一的输入信息:特征、logit或softmax概率,然而单一的信息无法应对分布多种多样的OOD样本。

方法介绍

|

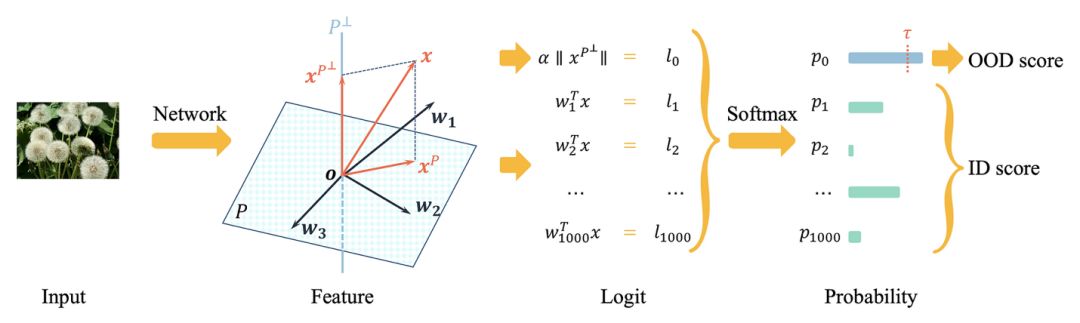

在一个特征向量空间维度大于种类数目的网络中,从特征空间到logit的降维会造成信息损失。这部分损失的信息对于ID数据影响可能不大,但是却包含了对于OOD数据判断有用的部分。另一方面,logit中包含着的ID信息对于判断OOD也起到一部分作用。因此,如何优雅地结合特征空间和logit两方面的信息就成为了问题的核心。

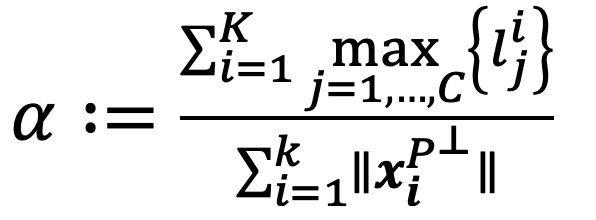

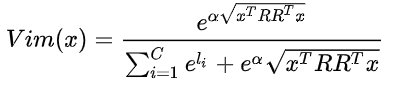

针对上面的问题,我们提出了Virtual logit的概念。Virtual logit推广了普通logit的定义,从feature与w向量的内积变为feature到某个子空间S的投影长度。 为了让virtual logit能表示OOD信息,我们将子空间S设定为所有训练样本特征构成的D维主空间P的正交补空间P⊥ 。这样在P⊥上投影越大,样本就越可能是OOD。为了让virtual logit的范围与原来的logit尺度相匹配,我们定义α为匹配系数:

|

其中x1, x2, …, xk 为均匀采样的k个训练样本,lij为特征向量xi的第j个logit。由此定义最终virtual-logit为

|

得到的virtual-logit与其他logit一起放入softmax得到最后每类的预测概率,而virtual-logit l0对应的p0即为样本为OOD的概率。 将P⊥的一组正交基写成矩阵R,那么完整表达式为

|

在这个式子里,如果原来的logit越大,那么ViM score越小,它越像ID。如果virtual logit越大,那么ViM score越大,它越有可能是OOD。

实验结果

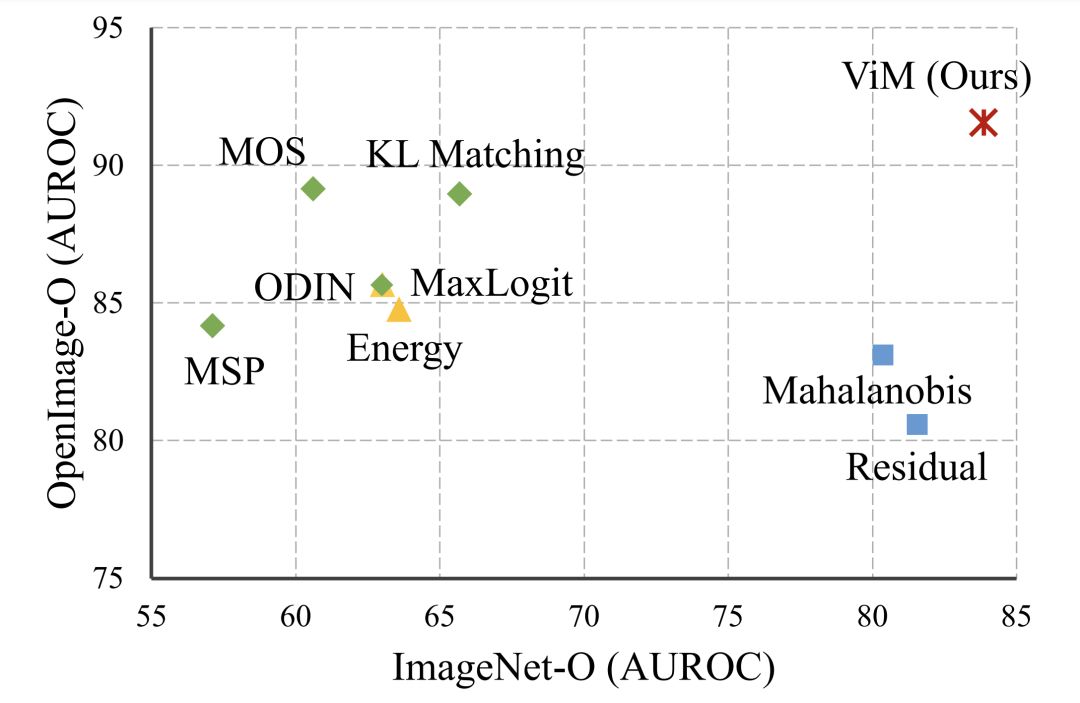

如图所示,在不同类型的OOD数据中,基于单一信息源如特征空间或logit的OOD检测方法的效果都相对局限在某些类型上的数据集上。而ViM能够在各种数据集上有更好的综合表现。此外,我们在包括CNN和vision transformer的多种网络结构上均进行了实验,在所有测试网络上ViM都有最高的平均AUROC得分。并且ViM比Mahalanobis以及KL Matching更加迅速便捷。

|

|

结语

我们提出了一个新的OOD检测算法ViM,能够结合特征和logit二者的信息,不借助额外的训练和数据,从不同的维度上有效地判断OOD数据。我们在包括基于CNN和transformer架构的多个网络上测试了ViM的性能,其结果展示了ViM的有效性。

OpenImage-O数据集

为了促进OOD检测的学术研究,我们还发布了当前最大的完全人工标注的OOD检测测试集OpenImage-O,是已知最大的OOD学术测试集的8.8倍。 不同于经典的OOD检测研究 [4, 6, 8]多基于CIFAR-10数据集,它以ImageNet-1K数据集为分布内样本集。 同时,我们以更接近自然分布的OpenImage-V3测试集为基础,采取了人工标注的方式挑选了OOD检测测试集,保证了测试集的质量。 OpenImage-O解决了现有OOD检测数据集或数量少,或有特定分布偏向,或标注粒度不精细、混有杂图的问题。

参考文献

[1] Haoqi Wang, Zhizhong Li, Litong Feng, and Wayne Zhang. ViM: Out-Of-Distribution with Virtual-logit Matching. In Proc. CVPR, 2022.

[2] Jingkang Yang, Haoqi Wang, Litong Feng, Xiaopeng Yan, Huabin Zheng, Wayne Zhang, and Ziwei Liu. Semantically coherent out-of-distribution detection. In Proc. ICCV, 2021.

[3] Jingkang Yang, Kaiyang Zhou, Yixuan Li, and Ziwei Liu. Generalized out-of-distribution detection: A survey. arXiv preprint arXiv:2110.11334, 2021.

[4] Dan Hendrycks and Kevin Gimpel. A baseline for detecting misclassified and out-of-distribution examples in neural networks. In ICLR, 2017.

[5] Dan Hendrycks, Steven Basart, Mantas Mazeika, Mohammadreza Mostajabi, Jacob Steinhardt, and Dawn Song. Scaling out-of-distribution detection for real-world settings. arXiv preprint arXiv:1911.11132, 2019.

[6] Dan Hendrycks, Mantas Mazeika, and Thomas Dietterich. Deep anomaly detection with outlier exposure. In ICLR, 2019.

[7] Kimin Lee, Kibok Lee, Honglak Lee, and Jinwoo Shin. A simple unified framework for detecting out-of-distribution samples and adversarial attacks. In NeurIPS, 2018.

[8] Shiyu Liang, Yixuan Li, and R Srikant. Enhancing the reliability of out-of-distribution image detection in neural networks. In ICLR, 2018.

[9] Weitang Liu, Xiaoyun Wang, John Owens, and Yixuan Li. Energy-based out-of-distribution detection. Advances in Neural Information Processing Systems, 33:21464–21475, 2020.

[10] Matthew Cook, Alina Zare, and Paul Gader. Outlier detection through null space analysis of neural networks. arXiv preprint arXiv:2007.01263, 2020.

[11] Rui Huang, Andrew Geng, and Yixuan Li. On the importance of gradients for detecting distributional shifts in the wild. In NeurIPS, 2021.

Copyright © 2022 Wayne Zhang.